Transformer中的FFN(前馈神经网络)设计为先升维再降维的原因在于,升维操作可以引入更多的非线性特征,增强模型的表达能力;而随后的降维操作则有助于减少计算量和过拟合风险。这种设计使得模型既能捕获丰富的上下文信息,又能保持较高的计算效率。

本文目录导读:

Transformer模型是近年来自然语言处理领域最流行的架构之一,其核心组件之一是Feed Forward Network (FFN),它在Transformer的每一层中都发挥着重要作用,在FFN中,我们经常可以看到一种特殊的操作模式:先进行升维,然后再进行降维,这种模式似乎违背了直觉,因为通常我们会尽量避免不必要的维度扩展和缩减,本文将探讨为什么这种先升维再降维的模式在Transformer的FFN中是必要的。

背景知识

为了理解为什么Transformer的FFN需要这种特殊的操作模式,我们首先需要了解FFN的基本结构和Transformer模型的工作原理。

1、Feed Forward Network (FFN):FFN是一个简单的神经网络层,通常包含多个线性层和非线性激活函数(如ReLU),在Transformer模型中,FFN负责处理输入数据并产生输出,以供下一层使用。

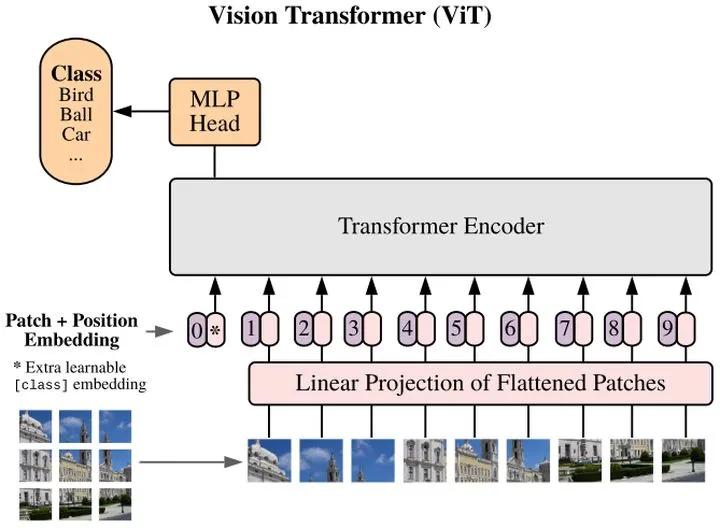

2、Transformer模型:Transformer模型主要由两个主要部分组成:Encoder和Decoder,每个Encoder和Decoder都包含多个相同的层,每个层都包含一个自注意力机制和一个FFN,自注意力机制负责捕捉输入数据的内部关系,而FFN则负责进一步处理数据。

为什么需要升维?

在Transformer的FFN中,先进行升维的主要原因在于增加模型的表达能力,通过扩展维度,我们可以为数据引入更多的特征,从而捕获更丰富的信息,升维操作允许模型在更高的维度空间中进行更复杂的计算和处理,升维还可以帮助模型更好地处理大规模数据集和复杂任务,升维是提升模型性能的关键步骤。

为什么需要降维?

尽管升维有助于提升模型的表达能力,但过高的维度也可能导致计算复杂性和过拟合问题,在升维之后进行降维是必要的,降维的主要目的是减少模型的计算复杂性并避免过拟合,通过减少数据的维度,我们可以降低模型的计算成本并提高泛化能力,降维还有助于可视化数据和揭示数据中的潜在结构,降维是平衡模型性能和计算效率的关键步骤。

先升维再降维的优势

在Transformer的FFN中,先升维再降维的模式具有以下优势:

1、提升模型的表达能力:通过升维操作,我们可以为数据引入更多的特征,从而增强模型的表达能力,这对于处理复杂任务和提高模型性能至关重要。

2、降低计算复杂性:虽然升维有助于提升模型的表达能力,但过高的维度可能导致计算效率低下,通过降维操作,我们可以降低模型的计算复杂性并提高计算效率。

3、避免过拟合:过高的维度容易导致过拟合问题,通过降维,我们可以减少模型的复杂度并降低过拟合的风险。

4、揭示数据中的潜在结构:降维有助于揭示数据中的潜在结构和关系,从而帮助模型更好地理解数据。

先升维再降维的模式在Transformer的FFN中是必要的,通过升维操作,我们可以增加模型的表达能力并处理更复杂的任务,过高的维度可能导致计算复杂性和过拟合问题,我们需要通过降维操作来平衡模型的性能和计算效率,通过先升维再降维的模式,我们可以在保证模型性能的同时,提高计算效率并避免过拟合问题,这种模式的运用体现了深度学习模型设计的巧妙之处,也反映了我们在追求模型性能和计算效率之间的平衡时所做出的努力。

京ICP备11000001号

京ICP备11000001号