摘要:本文主要探讨了AI领域的「蒸馏」概念。首先介绍了「蒸馏」的基本含义,即知识蒸馏,它是深度学习模型压缩和迁移学习的一种重要方法。接着详细解析了「蒸馏」在AI领域的应用,包括提高模型性能、加速模型训练、增强模型泛化能力等。最后指出,「蒸馏」在AI领域具有广泛的应用前景,是实现模型优化和高效应用的重要手段之一。

本文目录导读:

随着人工智能(AI)技术的飞速发展,许多新兴概念和术语不断涌现。“蒸馏”是近年来在AI领域备受关注的一个关键词,AI领域的“蒸馏”到底是什么意思?本文将围绕这一主题展开,带您深入了解“蒸馏”在AI领域的应用及其背后的原理。

AI领域的“蒸馏”概念解析

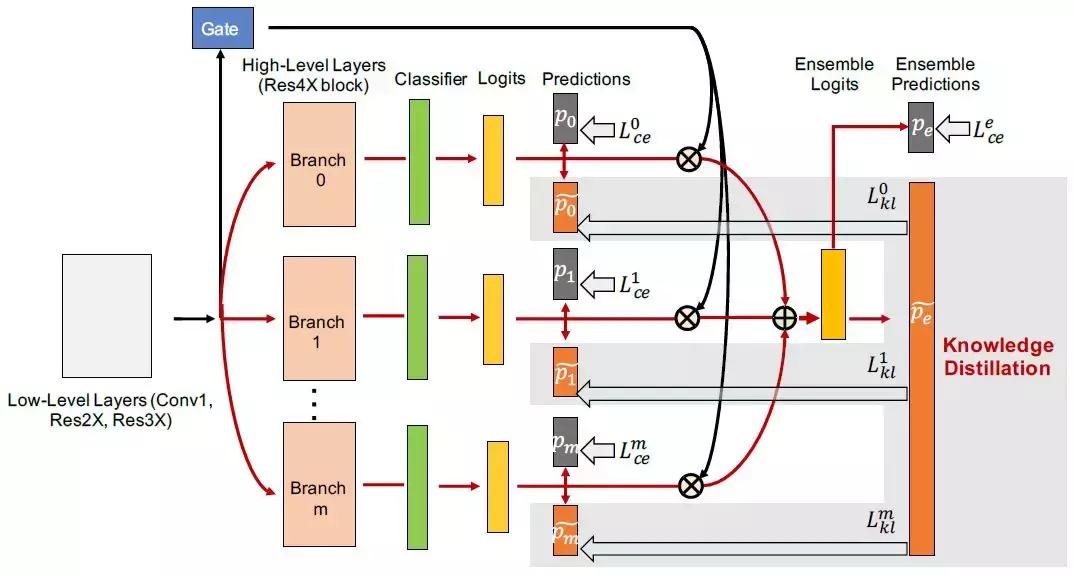

在AI领域,所谓的“蒸馏”,实际上是一种模型压缩技术,也被称为知识蒸馏(Knowledge Distillation),它的核心思想是将一个训练好的大型神经网络(教师模型)的知识迁移到一个较小的网络(学生模型)中,通过这种方式,学生模型能够在教师模型的指导下学习,从而在不损失太多性能的前提下降低模型的复杂性。

知识蒸馏的原理

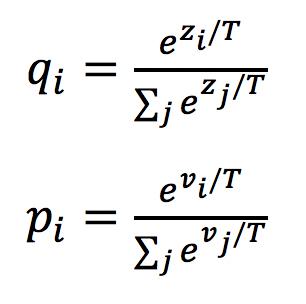

知识蒸馏的原理可以概括为三个阶段:训练、蒸馏和压缩,训练一个复杂的、深度较大的神经网络作为教师模型,通过蒸馏过程将教师模型中的知识转移到一个较小的学生模型中,在这个过程中,教师模型会将其预测的概率分布(软目标)传递给学生模型,而不仅仅是传统的硬标签,通过压缩技术减小学生模型的规模,使其在实际应用中更加高效。

知识蒸馏的应用场景

1、模型压缩:在嵌入式设备、移动设备等计算资源有限的环境中,模型压缩显得尤为重要,知识蒸馏可以帮助减小模型的规模,提高运行效率,同时保持较高的性能。

2、模型加速:随着深度学习模型的不断扩大,训练和优化变得越来越复杂,知识蒸馏可以加速模型的训练过程,提高训练效率。

3、模型优化:通过知识蒸馏,可以将一个复杂的模型的知识迁移到另一个更简单但性能相近的模型中,这有助于优化模型的性能,提高模型的泛化能力。

知识蒸馏的实践应用

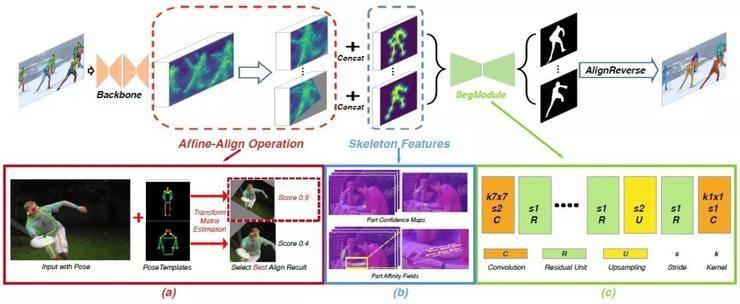

在实际应用中,知识蒸馏已经被广泛应用于计算机视觉、语音识别和自然语言处理等领域,在图像识别任务中,一个大型的教师模型可以将其对图像特征的理解传递给一个较小的学生模型,这样,即使在计算资源有限的情况下,学生模型也能达到较高的性能水平,知识蒸馏在自然语言处理领域也取得了显著的成果,尤其是在机器翻译和语音识别任务中。

知识蒸馏的挑战与未来发展方向

尽管知识蒸馏在AI领域取得了显著的成果,但仍面临一些挑战,如何设计有效的教师-学生模型架构以最大化知识的转移是一个关键问题,如何平衡教师模型和学生模型的性能也是一个挑战,随着AI技术的不断发展,知识蒸馏有望在更多领域得到应用,并与其他技术相结合,进一步提高模型的性能和效率。

AI领域的“蒸馏”指的是知识蒸馏技术,它是一种将复杂模型的知识迁移到较小模型中的方法,通过知识蒸馏,可以在不损失太多性能的前提下降低模型的复杂性,提高模型的运行效率和训练速度,知识蒸馏在模型压缩、模型加速和模型优化等方面具有广泛的应用前景,如何设计有效的教师-学生模型架构以及平衡两者性能仍是知识蒸馏面临的挑战,随着AI技术的不断进步,我们期待知识蒸馏在更多领域取得突破性的应用。

京ICP备11000001号

京ICP备11000001号